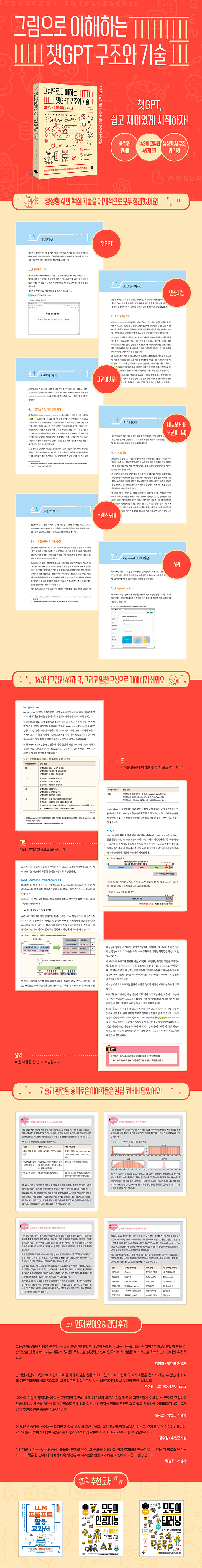

챗GPT는 어떻게 답을 만들어 낼까?

그림으로 알아보는 인공지능 구조와 원리!

챗GPT를 비롯한 생성형 AI를 쓰지 않는 사람을 찾기 힘들 정도로 이제는 당연하게 우리 삶과 함께 하고 있다. 하지만 기술의 변화 속도는 그만큼 빠르며, 새로운 기능과 모델이 끊임없이 등장하고 있다. 구조와 원리를 깊이 이해해 둔다면, 새로운 버전이 등장해 활용법이 변하더라도 당황하지 않고 안정적으로 대응할 수 있다. 이 책은 생성형 AI의 기반을 이루는 주요 기술과 원리를 체계적으로 설명한다. AI 기술을 전반적으로 다루고 있어서 챗GPT가 어떤 메커니즘으로 돌아가는지 파악할 수 있다. 특히 복잡한 개념들을 그림 213개와 표 17개로 일목요연하게 보여준다는 점이 큰 장점이다. 생성형 AI를 업무에 활용하고 있거나 다른 기술에 접목해야 한다면 이 책을 강력하게 추천한다!

목차

1장 챗GPT

1.1 챗GPT란

__1.1.1 챗GPT 시작

__1.1.2 챗GPT 활용 사례

1.2 편리한 챗GPT 기능

__1.2.1 채팅 답변 편집 및 조작

__1.2.2 채팅 기록 및 공유

1.3 프롬프트 엔지니어링

__1.3.1 프롬프트와 컨텍스트

__1.3.2 프롬프트 엔지니어링

1.4 챗GPT 엔진(대규모 언어 모델)

__1.4.1 GPT-4와 GPT-3.5

__1.4.2 웹 검색 연동 기능

__1.4.3 멀티모달 기능(이미지를 이용한 채팅)

__1.4.4 Code Interpreter(프로그램 자동 실행)

1.5 GPTs(AI의 커스터마이징 기능)

__1.5.1 GPTs

__1.5.2 GPT 빌더

1.6 챗GPT 이외의 AI 채팅 서비스

__1.6.1 구글 제미나이

__1.6.2 마이크로소프트 코파일럿

__1.6.3 앤트로픽 클로드

1.7 AI 채팅을 이용할 때 주의할 점

__1.7.1 무작위성이 존재한다

__1.7.2 오류 가능성

__1.7.3 금지된 행위

__1.7.4 입력 데이터 취급

__1.7.5 GPTs 이용할 때 주의 사항

2장 인공지능

2.1 AI(인공지능)

__2.1.1 인공지능이란

2.2 AI 역사

__2.2.1 AI 연구의 역사

2.3 생성형 AI와 범용 인공지능

__2.3.1 생성형 AI

__2.3.2 범용 인공지능(AGI)

3장 머신러닝과 딥러닝

3.1 머신러닝

__3.1.1 머신러닝 ≠ 기계가 스스로 학습하는 것

__3.1.2 머신러닝 종류

__3.1.3 추론과 학습

__3.1.4 최적화

__3.1.5 일반화와 과적합

3.2 신경망

__3.2.1 신경망이란

__3.2.2 신경망 구조

3.3 신경망의 학습

__3.3.1 경사 하강법을 이용한 학습

__3.3.2 오차 역전파법

3.4 정규화

__3.4.1 드롭아웃

__3.4.2 배치 정규화

__3.4.3 잔차 신경망

3.5 컴퓨터에서 숫자를 다루는 방법

__3.5.1 2진수로 정수와 소수 표현

__3.5.2 부동 소수점 수

__3.5.3 부동 소수점 수의 대표적인 형식

__3.5.4 부동 소수점 수의 정밀도와 동적 범위

3.6 양자화

__3.6.1 모델 크기와 GPU VRAM 관계

__3.6.2 양자화

3.7 GPU를 활용한 딥러닝

__3.7.1 계산을 빠르게 하는 방법

__3.7.2 GPU vs CPU

__3.7.3 GPU의 탄생과 범용 계산

__3.7.4 딥러닝에 특화된 GPU와 NPU

__3.7.5 GPU/NPU의 소프트웨어 지원

4장 자연어 처리

4.1 자연어 처리

__4.1.1 딥러닝 이전의 자연어 처리

__4.1.2 자연어 처리와 딥러닝

4.2 문자와 문자 코드

__4.2.1 문자 코드

__4.2.2 유니코드

4.3 단어와 토큰

__4.3.1 문장을 컴퓨터가 처리할 수 있도록 분할하기

__4.3.2 단어와 문자 기반 분할

__4.3.3 서브워드

4.4 토크나이저

__4.4.1 토큰나이저의 학습

__4.4.2 어휘 수와 토큰 수의 트레이드 오프

4.5 Word2Vec

__4.5.1 '개념'을 다루는 방식

__4.5.2 Word2Vec으로 단어의 벡터 표현

__4.5.3 Word2Vec이 단어 의미를 파악하는 원리

4.6 임베딩 벡터

__4.6.1 토큰 벡터는 '의미'를 나타내지 않는다

__4.6.2 임베딩 벡터

__4.6.3 다양한 임베딩 벡터

5장 대규모 언어 모델

5.1 언어 모델

__5.1.1 모델이란

__5.1.2 언어 모델이란

5.2 대규모 언어 모델

__5.2.1 대규모 언어 모델과 '일반적인 언어 능력'

5.3 신경망의 범용성과 기반 모델

__5.3.1 신경망으로 특징 추출

__5.3.2 기반 모델

__5.3.3 기반 모델로 정확도가 향상되는 원리

5.4 스케일링 법칙과 창발성

__5.4.1 스케일링 법칙과 창발성

__5.4.2 대규모 언어 모델의 파라미터 수

5.5 언어 모델이 텍스트를 생성하는 원리

__5.5.1 언어 모델의 텍스트 생성

__5.5.2 자기 회귀 언어 모델

__5.5.3 탐욕법

5.6 텍스트 생성 전략

__5.6.1 랜덤 샘플링과 소프트맥스 함수

__5.6.2 '온도'의 역할

__5.6.3 단어 생성의 트리 다이어그램

__5.6.4 빔 서치

5.7 언어 모델을 이용한 AI 채팅

__5.7.1 문장 생성을 이용한 AI 채팅

__5.7.2 대규모 언어 모델을 이용한 AI 채팅의 문제점

5.8 로컬 LLM

__5.8.1 로컬 LLM이란

__5.8.2 로컬 LLM 환경

__5.8.3 로컬 LLM을 이용한 추론 과정

5.9 대규모 언어 모델의 라이선스

__5.9.1 로컬 LLM의 생태계

__5.9.2 소프트웨어 라이선스

__5.9.3 대규모 언어 모델의 라이선스 종류

5.10 대규모 언어 모델의 평가

__5.10.1 대규모 언어 모델의 평가 방법

__5.10.2 리더보드

5.11 대규모 언어 모델의 학습: 사전 학습

__5.11.1 사전 학습과 기반 모델

__5.11.2 자기 지도 학습

__5.11.3 기반 모델의 추가 학습

__5.11.4 사전 학습의 훈련 데이터

5.12 대규모 언어 모델의 학습: 파인튜닝

__5.12.1 파인튜닝

__5.12.2 파인튜닝 방법

__5.12.3 RLHF

__5.12.4 LoRA

5.13 컨텍스트 내 학습

__5.13.1 문맥 내 학습

6장 트랜스포머

6.1 회귀형 신경망(RNN)

__6.1.1 벡터의 차원

__6.1.2 회귀형 신경망

__6.1.3 언어 모델로서 RNN

__6.1.4 장거리 의존성과 LSTM

__6.1.5 인코더-디코더

6.2 주의 메커니즘

__6.2.1 인간의 인지와 주의 메커니즘

__6.2.2 주의 메커니즘의 기본

__6.2.3 인코더-디코더와 주의 메커니즘

6.3 주의 메커니즘의 계산

__6.3.1 주의 메커니즘 계산

__6.3.2 주의 메커니즘이 잘 작동하는 이유

6.4 트랜스포머

__6.4.1 트랜스포머의 기본 구성

__6.4.2 위치 인코딩

__6.4.3 멀티헤드 주의 메커니즘

6.5 BERT

__6.5.1 BERT(버트) 특징

__6.5.2 BERT의 사전 학습

6.6 GPT

__6.6.1 GPT 모델의 기본 구조

__6.6.2 Mixture of Experts

7장 API를 이용한 AI 개발

7.1 OpenAI API 활용

__7.1.1 OpenAI API

__7.1.2 OpenAI API를 이용할 때 주의 사항

7.2 텍스트 생성 API(Completion API 등)

__7.2.1 텍스트 생성 API의 종류

7.3 OpenAI API 요금

__7.3.1 OpenAI API의 토큰

__7.3.2 텍스트 생성 모델의 종류와 요금

__7.3.3 OpenAI 토크나이저 라이브러리 tiktoken

__7.3.4 언어별 토큰 수 차이

7.4 텍스트 생성 API에 지정하는 파라미터

__7.4.1 텍스트 생성 API의 파라미터

7.5 텍스트 생성 API와 외부 도구의 연계: Function Calling

__7.5.1 Function Calling

__7.5.2 랭체인 라이브러리

__7.5.3 기계가 읽을 수 있는 도구로써 Function Calling

7.6 임베딩 벡터 생성 API와 규약 위반 검사 API

__7.6.1 임베딩 벡터 생성 API

__7.6.2 임베딩 벡터 생성 API의 모델 종류

__7.6.3 약관 위반 검사(Moderation) API

7.7 OpenAI 이외의 대규모 언어 모델 API 서비스

__7.7.1 마이크로소프트 Azure OpenAI API

__7.7.2 구글, Vertex AI

__7.7.3 아마존, Bedrock

7.8 RAG

__7.8.1 외부 지식을 활용한 AI 애플리케이션 개발

__7.8.2 RAG

8장 대규모 언어 모델의 영향

8.1 생성형 AI의 위험과 보안

__8.1.1 생성형 AI가 미치는 악영향

__8.1.2 생성형 AI의 악용

__8.1.3 생성형 AI가 부적절한 출력을 할 위험

__8.1.4 생성형 AI를 이용한 서비스 공격

__8.1.5 대책과 가이드라인

8.2 AI의 편향과 정렬

__8.2.1 학습 데이터의 편향이 AI에 미치는 영향

__8.2.2 AI의 편향성을 제어하는 방법

8.3 환각

__8.3.1 AI는 실수한다

__8.3.2 환각의 정체

__8.3.3 환각의 대책

__8.3.4 환각을 없앨 수 있을까?

8.4 AI의 민주화

__8.4.1 AI 활용의 민주화

__8.4.2 AI 개발의 민주화

__8.4.3 빅테크의 컴퓨팅 자원

8.5 대규모 언어 모델의 다국어 지원

__8.5.1 챗GPT는 몇 개 언어로 사용 가능한가요?

__8.5.2 대규모 언어 모델의 언어 간 격차

__8.5.3 대규모 언어 모델과 인지, 문화와의 관계

8.6 AI와 철학

__8.6.1 지능이란, 언어란

__8.6.2 중국어의 방

저자&기여자

ㆍ지은이 나카타니 슈요

- 소개

- 사이보즈 랩 주식회사 소속. 어린 시절부터 프로그램과 소설을 집필해 왔으며, 현재는 머신러닝, 자연어 처리, 대규모 언어 모델(LLM)을 중심으로 연구 및 개발을 하고 있다. 저서로는 『[프로그래밍 체험 만화] 펫 스크립트 – 만약 프로그래밍 가능한 스티커가 있다면』, 『이해할 수 있는 기계 학습 - 현실의 문제를 해결하기 위해 구조를 이해한다』(이상 기술평론사)가 있다.

ㆍ옮긴이 박광수

- 소개

- 박광수라는 이름보다 '아크몬드'라는 필명으로 알려진 블로거이다. 2004년부터 지금까지 최신 윈도우 정보를 꾸준히 나누고 있다. 지금까지 7회 마이크로소프트 MVP(Windows 부문)를 수상했다. Microsoft 365, 애저 등 마이크로소프트의 최신 기술에 열광한다. 심리학에 관심이 많으며 현재 일본에서 개발자로 일하면서 딥러닝에 많은 관심을 두고 있다. 지은 책으로는 『진짜 쓰는 윈도우 11』(제이펍, 2023), 『윈도우 10 마스터북』(한빛미디어, 2016), 옮긴 책으로는 『처음 배우는 딥러닝 수학』, 『파이썬으로 배우는 머신러닝의 교과서』 (이상 한빛미디어) 등이 있다.

저작권 안내

인공지능(AI) 기술 또는 시스템을 훈련하기 위해 자료의 전체 내용은 물론 일부도 사용하는 것을 금지합니다.

All materials are protected by copyright law and may not be edited or reproduced in other media without permission.

It is prohibited to use all or part of the materials, including for training artificial intelligence (AI) technologies or systems, without authorization.

연관 프로그램

무료로 사용할 수 있는 정보를 안내해 드리니, 지원이 필요하면 해당 프로그렘 제작사로 문의해 주세요.

독자의견 남기기